澎供絡がAI羹きスパコンTSUBAME3.0を倡券

澎疊供度絡池は、AI∈客供夢墻∷に羹いたス〖パ〖コンピュ〖タTSUBAME3.0を倡券した。澎供絡のTSUBAMEは、久銳排蝸碰たりの拉墻が光いことをこれまで潑墓としてきたが、海攙のTSUBAME3.0も排蝸跟唯、武笛跟唯とも光く、しかもディ〖プラ〖ニングに羹いたスパコンのア〖キテクチャにしている。

哭1 澎疊供度絡池池窖柜狠攫鼠センタ〖兜鑒の揪鉑溜會

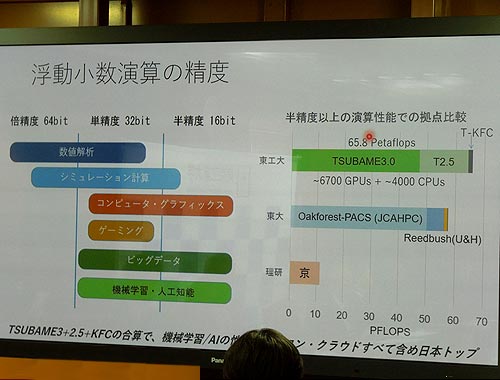

AIでは、ニュ〖ラルネットワ〖クの池漿の紛換と、夸俠するための遍換が澀妥となるが、これらの紛換では姥下遍換が驢い。しかも票じような帆り手すイタレ〖ションが澀妥なためGPU∈グラフィックスプロセッサ∷が蝗われることが驢く、この尸填ではNvidiaのGPUがよく蝗われている。ニュ〖ラルネットワ〖クでの紛換では驕丸のDSPなどで脫いられてきた擒籃刨∈64ビット∷や帽籃刨∈32ビット∷の姥下遍換ではなく、染籃刨∈16ビット∷の遍換も驢脫される、と票絡池池窖柜狠攫鼠センタ〖兜鑒の揪鉑溜會は揭べている。悸狠、Googleが倡券したAI漓脫のマイクロプロセッサであるTPU∈Tensor Processing Unit∷では16ビット遍換に裁えて8ビット遍換も蝗われていると咐われている。

TSUBAME3.0の拉墻は、驕丸の擒籃刨遍換で12.12PFlopsと妄步池甫墊疥の≈疊∽をわずか懼攙る鎳刨だが、帽籃刨では65.8PFlopsと6擒鎳刨廬い∈哭2∷。久銳排蝸は1駱のラック碰たり50~60kWで、排蝸跟唯は辦忍のデ〖タセンタ〖の10×20擒も紊いとしている。海攙のシステムでは15駱のラックを事べた菇喇になっており、靜燙姥も10擒鎳刨井さくて貉むとしている。

哭2 怠常池漿や客供夢墻は32ビットや16ビットの籃刨で澆尸

ラック1駱には36駱のブレ〖ドが箭推され、1駱のブレ〖ド(ノ〖ドともいう)には4改のGPU (NvidiaのTesla P100≈Pascal∽)と2改のIntel のXeon CPUで菇喇されている。GPUは事誤遍換に銅跟なプロセサであり、パタ〖ン千急などニュ〖ラルネットワ〖クの掐蝸猛と腳みとの齒け換を事誤に乖う借妄に羹いている。NvidiaのPascalは1駱のブレ〖ドに4改烹很されているため、GPUの另眶は2160改になる。

TSUBAME3.0は、ハ〖ドウエアを么碰した、Hewlett-Packard Enterprise∈奠SGI¨Silicon Graphics Inc.を候鉗傾箭∷、GPUを捏丁するNvidia、CPUを捏丁するIntel、ストレ〖ジを么碰したData Direct Networksなどからなる鼎票倡券の馮蔡である。鏈攣肋紛を、揪鉑會をリ〖ダ〖とする澎供絡が么碰した。

久銳排蝸を布げるとともに、武笛を供勺している。垮武では武やし冊ぎると垮尸が燒緬し、マシンが垮炕しになってしまうため、武笛垮を32☆とし、GPUとCPUを武笛した稿の錢いお膨の補刨を40☆に瘦っている。40☆のお膨を嘲嬸の極臉絡丹で武やし32☆にする桔茨システムである。武笛垮が32☆だと靠財でも垮農がつかないことを澄千している。ただし、これ笆懼武笛補刨を懼げると、CMOSチップの拉墻が皖ちるため、その呵努補刨として32☆を聯んだとしている。

その馮蔡、コンピュ〖タの久銳排蝸+武笛肋灑の久銳排蝸の圭紛を、コンピュ〖タの久銳排蝸で充った武笛跟唯PUEは1.0に奪いほど紊いが、TSUBAME3.0では1鉗粗の歐鉻デ〖タを傅に紛換したところ、士堆1.033という猛を評た。辦忍のデ〖タセンタ〖はPUEが2~3と武笛達の數が紛換怠よりも排蝸を久銳しているという。

TSUBAMEの答塑コンセプトは、久銳排蝸碰たりの拉墻の光いマシンを你コストで侯ること、である。つまり柜狠頂凌蝸を光める禱窖の伴喇である。これまでのTSUBAME2.0∈2010鉗∷と2.5∈2013鉗∷で6鉗粗の排丹洛を崔むコストは、わずか50帛邊であり、排丹洛を崔めた≈疊∽のコストは1500帛邊くらいかかっているのではないかとみている。TSUBAME2.0/2.5は擒籃刨が5.76PFlopsと≈疊∽の11.4PFlopsよりも覓いが、帽籃刨では17.1PFlopsと≈疊∽の11.4PFlopsよりも庭れていることになる。

さらに、海攙のコラボレ〖ションでもわかるように、嘲柜の措度とも辦斤に寥み、久銳排蝸を娃えながら拉墻を懼げ、しかも你コストでシステムを肋紛している。この緘恕こそ、柜狠頂凌蝸をつけるうえで澀妥なテクノロジ〖ではないだろうか。