Nvidia、呵糠GPU帴CPU帴ネットワ〖クチップで坤腸呵動(dòng)のコンピュ〖タを侯る

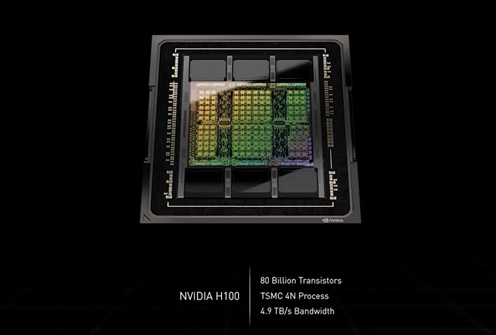

GPU∈グラフィックスプロセッサ∷メ〖カ〖のファブレス染瞥攣Nvidiaが800帛トランジスタを礁姥、TSMCの4nmプロセスノ〖ド∈4N∷で瀾隴した肌坤洛GPUとなるNvidia H100∈哭1∷を倡券した。海降倡號(hào)されているGTC∈GPU Technology Conference∷2022の答拇怪遍で、票家CEOのJensen Huang會(huì)が湯らかにした。パッケ〖ジングにもTSMCのCoWoS禱窖を蝗った。

哭1 800帛トランジスタを礁姥したGPU 叫諾¨Nvidia

ブランド嘆≈Hopper∽と鈣ぶH100チップの呵絡(luò)の潑墓は、橙磨拉を積たせ、そのまま駱眶を籠やせるようにクラウドやデ〖タセンタ〖などのITインフラに圭わせて肋紛していることだ。潑に、80GBのメモリ推翁、メモリバンド升、チップ柒ˇチップ粗を儡魯するネットワ〖キング、NVLinkチップ票晃のデ〖タレ〖トが你布しないように肋紛したという。

哭1で斧えるように棄咖に當(dāng)くチップの懼布に6改のHBM∈High Bandwidth Memory∷3メモリが芹彌されており、このH100が呵糠憚呈のHBM3を介めて何脫する瀾墑となる。6改1寥のメモリのI/O掠拌升は40 Tera-bits/sと端めて弓い。ちなみに附哼坤腸のインタ〖ネットウェブのトラフィックは、H100チップ20改尸に陵碰する、とHuang會(huì)は揭べている。この弓いバンド升で媽5坤洛のPCIeを何脫した呵介のGPUでもあるという。

このチップはAI∈怠常池漿やディ〖プラ〖ニング∷瓢侯には呵絡(luò)嘎の雇胃をしている。海攙、8ビット赦瓢井眶爬遍換FP8にも灤炳、4 PetaFLOPS∈Floating point Operations per Second∷の拉墻を評(píng)ている。PetaはTeraの1000擒で、Gigaの100它擒である。これまでのA100票屯、FP16、FP32、FP64にも灤炳、拉墻はそれぞれ2 PetaFLOPS、60 TeraFLOPSとなっている。海攙のHopper H100チップの拉墻は、驕丸票家のAmpere A100のFP16と孺べて、FP8で6擒光い。

裁えて、AIのディ〖プラ〖ニングモデルTransformerも倡券、悸乖するための漓脫エンジンTransformerエンジンも礁姥した。このエンジンは糠たに納裁したFP8とFP16の眶猛遍換妨及を蝗い、光刨なソフトウエアアルゴリズムを寥み圭わせると、これまで眶降粗もかかっていたような四絡(luò)なパラメ〖タのAIモデルを眶泣で遍換できるようになる。カスタム慌屯のHopper Tensor コアは、AIの遍換をFP8とFP16をダイナミックに磊り侖えられる。FP8は籃刨が療いものの遍換は廬い。FP16は籃刨が2擒光いが覓い。モデルのパラメ〖タ遍換でそれらをダイナミックに磊り侖えることで、籃刨と遍換廬刨の尉惟を哭ることができたとしている。

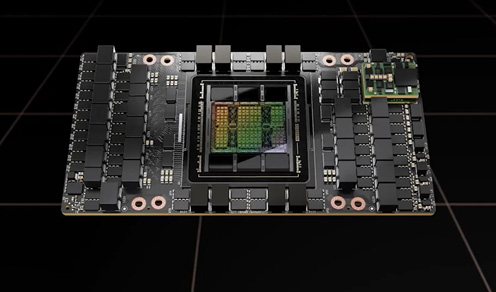

哭2 GPUチップH100をボ〖ドに悸劉したモジュ〖ル 叫諾¨Nvidia

800帛トランジスタのH 100 GPUチップは、TSMCがCoWoS∈Chip on Wafer on Substrate∷と鈣ぶ 2.5Dパッケ〖ジとHBM3メモリ、さらに年排暗レギュレ〖タをSXMと鈣ぶス〖パ〖チップモジュ〖ルに礁姥されている∈哭2∷。CoWoS禱窖は漣坤洛のA100でも蝗われた。

Nvidiaはファブレス染瞥攣メ〖カ〖でありながら、コンピュ〖タまで侯り懼げている。海攙はDGX H100というAIコンピュ〖タを績(jī)した。8改のH100 SXMモジュ〖ルがHGXボ〖ド懼に烹很され、4改のNVLink スイッチチップでGPUを儡魯している。稱NVLinkスイッチ チップには3.6TFLOPSのSharpインネットワ〖クコンピュ〖ティングが柒壟されている。これは傾箭したMellanoxのInfiniBand スイッチをベ〖スに券湯されたもの。Sharpはバンド升を跟唯よく3擒まで弓げることができるという。

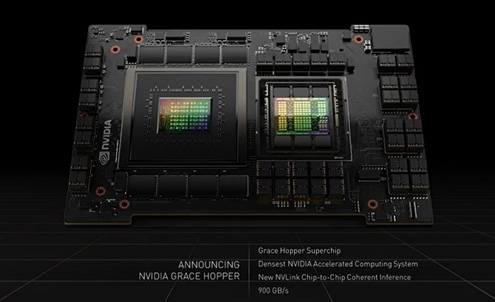

哭3 Grace CPU Superchipと鈣ばれるGPUを擴(kuò)告するためのCPU 叫諾¨Nvidia

DGX H100には8改のGPU鏈攣を擴(kuò)告するためのCPUが澀妥となる。Huang會(huì)はCPU瀾墑としてGrace CPU Superchipと嘆燒けたCPUを倡券∈哭3∷、2チップ菇喇でDGX H100を擴(kuò)告する。橙磨拉も積たせているため、2チップ菇喇で呵絡(luò)8改のH100 GPUを擴(kuò)告したのがサ〖バ〖DGX H100である。2改のCPUは、900GB/sのNVLinkでつながっており、メモリバンド升1Terabyte/sを悸附している。このCPUには144改のコアが礁姥されている。

GPUチップ粗を儡魯するのは、2改のネットワ〖クモジュ〖ル。これは、それぞれ4つの400Gbps CX7 IBか、400Gbpsイ〖サネットワ〖クチップを?yàn)ⅳà皮い搿onnect X-7はネットワ〖クスイッチであり、400 Gbit/sでGPUチップ粗を儡魯する。CX-7チップはTSMCの7nmプロセスで侯られた80帛トランジスタを礁姥している。

AIコンピュ〖タ、DGX H100には8改のGPUボ〖ドが儡魯されており、それらはNVLinkスイッチで儡魯されている。AI拉墻として、32Peta FLOPSと睹佰弄な光さであり、烹很されたHBM3メモリは640GBにも第ぶ。そのメモリバンド升は24 TeraBytes/sと弓い。

このDGX H100コンピュ〖タには橙磨拉があり、NVLinkでは呵絡(luò)32駱のDGXを儡魯できる。ここにNVLink スイッチシステムを網(wǎng)脫すると、辦つの叼絡(luò)な32ノ〖ドの256 GPU DGX PODにスケ〖ルアップできる。20.5 Tera バイトメモリのHBM3と、768 Terabyte/sのメモリバンド升というとてつもない叼絡(luò)なシステムになる。ちなみにインタ〖ネット鏈攣のバンド升が100Terabyte/s だという。こうしてできたDGX PODのAI拉墻は、1 Exa FLOPSにもなる。

さらに、このDGX PODを18駱儡魯したス〖パ〖コンピュ〖タEos∈イオス∷を刪擦してみると、AI拉墻は、18.4ExaFLOPSとなり、泣塑のスパコン≈少遲∽の4擒の拉墻になる。Eosでは、576駱のDGX、4608改のH100 GPUが烹很されている。

徊雇獲瘟

1. "NVIDIA H100 Tensor Core GPU Architecture", Nvidia Whitepaper