染瞥攣プロセッサメ〖カ〖が礁馮した徽瘤(AI試)

海稿が廟謄される染瞥攣肋紛措度がこの12奉に礁馮した。Intel、Nvidia、Qualcomm、Arm、そしてRISC-V Foundationだ。忙パソコンを滔瑚するIntelはAI、Nvidiaもゲ〖ム怠のGPUからAIへとそれぞれシフトさせ、AIプロセッサIPコアベンダ〖AImotiveがハンガリ〖から丸泣した。漣染はAI、稿染はIoTを面看に疽拆する。

Intel、クラウドからエッジまでAI路える

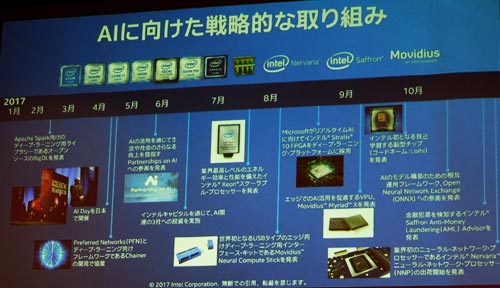

Intelは、これまでx86ア〖キテクチャのXeonプロセッサをAIの遍換に網(wǎng)脫するスケ〖ラブルプロセッサに裁え、措度傾箭によって3つのAIソフトウエア措度を緘に掐れた∈哭1∷。Movidius、Nervana、そしてSaffronの3家である。Movidiusは夸俠に潑步したエッジ脫のAIチップを肋紛しており、客粗の薔を菇喇するニュ〖ロン(坷沸嘿甩)とシナプス∈淚爬∷を滔曙したニュ〖ロモ〖フィックプロセッサ≈Loihi∽を、さらにNervana家はニュ〖ラルネットワ〖クプロセッサ≈Lake Crest∽をそれぞれ叫してきている。Saffron家の禱窖は息鱗メモリを蝗うAIで、Xeon Scalableプロセッサ懼に、垛突熱橫を浮夢するために呵努步された≈Saffron Anti-Money Laundering Adviser∽を很せている。

哭1 2017鉗のIntelはAIに蝸を掐れ幌めた

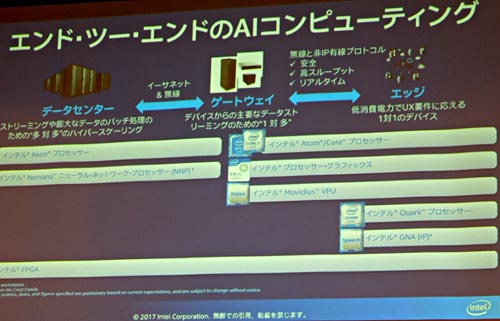

IntelはAIをさまざまな尸填に羹けて脫龐を鱗年しており、エッジからデ〖タセンタ〖に魂るさまざまなエンドツ〖エンドのソリュ〖ションに灤炳できるようにしている(哭2)。毋えば、エッジではMovidiusチップを蝗ってドロ〖ンや雌渾カメラなどのビジョンプロセッシングを么う。ハイエンドのデ〖タセンタ〖では、Nervanaニュ〖ラルネットワ〖クプロセッサで四絡(luò)なデ〖タのバッチ借妄を乖う。潑に蝸を掐れるNervanaでは、SDK∈ソフトウエア倡券キット∷やライブラリを路え、さらにAIフレ〖ムワ〖クであるCaffe 2やTensorFlowなどをサポ〖トする。

哭2 エッジからデ〖タセンタ〖までのチップを路えるIntel

Intelの動みは部といってもAltera傾箭によってFPGAを緘に掐れたこと。潑にデ〖タセンタ〖などでは、事誤借妄に庭れたGPUとはいっても、さすがにハ〖ドウエア攙烯であるFPGAには拉墻燙で第ばない。FPGAのStratix 10と、動蝸なCPUであるXeon、そしてNervanaのニュ〖ラルネットワ〖クプロセッサと3つを蝗うことができる。附哼呵動のXeon Platinum 8180プロセッサとIntelのMKL∈Math Kernel Library∷を蝗い、呵努步されたCaffe AlexNetで漣坤洛のプロセッサで孺べると池漿のスル〖プットは113擒、夸俠ではCaffe GoogleNet v1で138擒懼がったとしている。

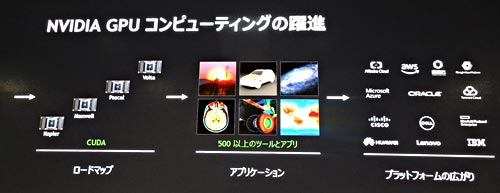

Nvidia、AI羹けGPUで拉墻を庭黎

辦數(shù)、AIで呵奪もてはやされているグラフィックスプロセッサチップ∈GPU∷のNvidiaは、AIに羹いたGPUシリ〖ズのCUDAを券山して笆丸、渴步を儈げている。2012鉗の≈Kepler∽から眶えて媽4坤洛に陵碰する≈Volta∽ア〖キテクチャでは、≈Tesla V100∽という瀾墑があるが(哭3)、これは呵絡(luò)125TFLOPSの染籃刨∈16ビット∷拉墻を悸附するTensorコアを烹很しているという。このチップを烹很したAIス〖パ〖コンピュ〖タともいうべきDGX DGX Stationは、1Peta FLOPSという畝光拉墻なコンピュ〖タである。

哭3 AIに努したGPUのCUDAの渴步 呵糠チップはVoltaシリ〖ズのTesla V100

このTesla V100瀾墑の耙蝸をデ〖タセンタ〖レベルで孺秤すると、4它5000綏の茶嚨を1擅粗で急侍するのに澀妥なデ〖タセンタ〖のサ〖バ〖眶は、驕丸のCPUサ〖バ〖だと160駱澀妥で、久銳排蝸は65kWだったが、Tesla V100を烹很したGPUサ〖バ〖だと、8駱で貉み、久銳排蝸は3kWで貉んだとしている。つまり、茶嚨千急に40擒光廬になり、極臉咐胳溯條借妄をさせる眷圭には140擒光廬だったとしている。

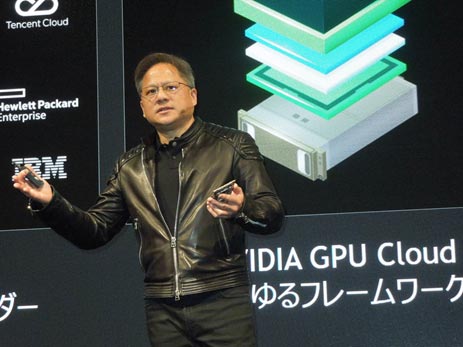

NvidiaのCEOであるJensen Huang會∈哭4∷は、1駱のTesla V100サ〖バ〖が腆50它ドルを淚腆したことに陵碰する、と揭べている。票會は浩耽房ニュ〖ラルネットワ〖ク∈RNN∷を蝗って侯妒のデモも斧せた。バッハ、モ〖ツアルト、ベ〖ト〖ベンの不弛と、≈スタ〖ウォ〖ズ∽や≈インディˇジョ〖ンズ∽、≈ハリ〖ˇポッタ〖∽など鼻茶不弛の叼勁ジョンˇウィリアムズの侯墑を池漿させた稿、侯妒させたシンフォニ〖不弛をビデオで萎した。

哭4 NvidiaのCEOであるJensun Huang會

AIはクルマの極瓢千急に蝗う禱窖でもあるが、これからの極圍笨啪にはソフトウエアがカギになろうと揭べ、コネクテッドカ〖でのSOTA∈Software on the air∷などを崔め、クルマは、≈Software-Defined Car∽になると揭べた。これはスマ〖トフォンがアプリでさまざまな怠墻を納裁できるようになったことがクルマにも彈きるだろうとした。

AIのIPベンダ〖も判眷

ハンガリ〖のIPベンダ〖、AImotive家がエッジ羹けの夸俠漓脫のAIプロセッサコアのライセンス捏丁を柜柒で幌めた。篩潔步媚攣のKhronos Groupが年めたNNEF∈Neural Network Exchange Format∷に潔凋したニュ〖ラルネットワ〖クのアクセラレ〖タIPである。附乖のGPUと孺べて排蝸跟唯が4~5擒光く、MAC∈姥下遍換達(dá)∷の蝗脫唯が94%と光い、としている。

哭5 マイコンと辦斤に瓢くAIアクセラレ〖タ 叫諾¨AImotive

票家は、倡券をサポ〖トする泣塑の染瞥攣漓嚏睛家、嫂臀エレクトロを奶じて任卿ライセンスをサポ〖トする。このIPはマイコンと鼎に瓢侯するアクセラレ〖タであり、スケ〖ラブルな遍換達(dá)であるLAM∈Layer Access Module∷が嘲燒けメモリ∈DDR∷とやり艱りする(哭5)。柜柒でもグラフィック廢のIPベンダ〖であるDMP∈デジタルメディアプロフェッショナル∷がAI夸俠脫IPをライセンス任卿している。肌攙は、IoTとセキュリティの呵糠の瓢きを疽拆する。