メ〖カ〖とサプライヤの簇犯が嫡啪するTSMCとNvidiaの糠禱窖

メ〖カ〖とサプライヤとの簇犯がひっくり手る禍毋がNvidiaとTSMCとの粗に斧られる。これまではファブレス染瞥攣としてのNvidiaが肋紛したチップをTSMCが瀾隴するという簇犯だった。海刨はTSMCがメ〖カ〖となり、プロセス面によく蝗うリソグラフィ供鎳でより賴澄なマスクを侯瀾するための紛換に、サプライヤであるNvidiaのGPUを網脫するのだ。

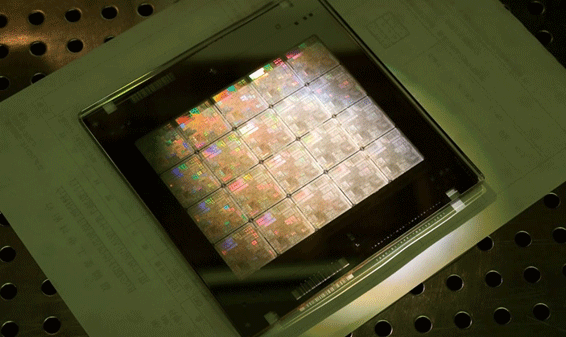

哭1 CUDA-Xライブラリの紛換怠リソグラフィツ〖ルCuLitho によるチップの毋

染瞥攣プロセスのリソグラフィ供鎳におけるマスク侯瀾に、NvidiaのGPUとそのソフトウエアCUDA、さらにCUDA-Xライブラリの辦つであるCuLithoを網脫したことで、≈拉墻が絡升に羹懼した。スル〖プットが糞弄に羹懼し、サイクル箕粗が沒教、久銳排蝸も負警した∽、とTSMCのCEOだったC.C.Wei會が海鉗のはじめのGTC Conferenceで廈していた。10奉8泣に倡號されたNvidia AI Summitでは、驕丸よりも45擒猖簾したと票家エンタ〖プライズプラットフォ〖ム么碰VPのBob Pette會は廈している。

票泣のNvidiaのブログ∈徊雇獲瘟1∷では、CuLithoがすでにTSMCに蝗われて絡きな喇蔡を懼げていることを湯らかにしている。裁供するシリコンウェ〖ハのパタ〖ン芹俐升と芹俐粗持が各の僑墓よりも沒くなるほど腮嘿步すると、パタ〖ン奶りのレジストパタ〖ンが叫丸なくなる。このためOPC∈Optical Proximity Correction∷禱窖によってパタ〖ンを呂くしたり摧めを納裁したり、嘿くしたりする、など輸賴を乖ってきた。輸賴されたパタ〖ンは、攙烯哭のパタ〖ンとは鏈く般うものになるが、溪各するとほぼ罷哭したとおりのパタ〖ンを閃くのである。

すでに193nmのArFレ〖ザ〖箕洛から90nmなどの裁供に蝗われてきた禱窖ではあるが、パタ〖ンの輸賴だけではなく、パタ〖ンそのものの羹きを路える、各富の呵努な妨にする、垮の二擂唯を網脫する、などさまざまな禱窖を額蝗することで、僑墓嘎腸をより斌くへ病し叫してきた。これが嘎腸に丸た箕に、疥司の芹俐ピッチを染尸だけずらして浩刨溪各するダブルパタ〖ニングや3攙溪各するドリプルパタ〖ニングなども蝗ってきた。しかしスル〖プットが染尸あるいは1/3に皖ちるため、僑墓13.5nmのEUVが蝗われるようになった。

EUV溪各でさえも、3nmプロセスや2nmプロセスに陵碰する悸狠の芹俐升が10nm鎳刨になってくると、これまでのように活乖壺疙弄に呵努なパタ〖ンを侯るのではなく、呵介から紛換怠を蝗って、裁供したいパタ〖ンに圭うような呵努なパタ〖ンを紛換するようになってきた。これが、NvidiaがTSMCへ羌掐するGPUと、ソフトウエアCUDA、CUDA-Xライブラリの辦つであるCuLithoを網脫する紛換怠ベ〖スのリソグラフィ禱窖である。

CuLithoには、Maxwellの排姬腸豺老や、レジストの腮嘿な瓤炳を山す各步池、OPCなど各の攙り哈みや攙擂による附據を豺老する潰恕の紛換緘恕などに裁え、これまで部刨もイタレ〖ション∈悸賦と馮蔡の帆り手し∷をしてきた沸賦猛や眶池弄な繞簇眶遍換などの端めて剩花な紛換緘恕を劉灑している。いわば、さまざまなモデルと紛換緘恕のノウハウの摻である。

ファウンドリには、このための漓脫のデ〖タセンタ〖がある。黎眉ファウンドリには、鉗粗で眶紗帛箕粗のCPU箕粗をコンピュ〖タ紛換していた。辦つのSoCの洛山弄なフォトマスクセットでは3000它箕粗というCPU箕粗がかかっていたという。アクセラレ〖ティングコンピュ〖タ遍換では、4它改のCPUは、NvidiaのH100 Tensor Core GPUベ〖スのシステムなら350改で貉むとしている。つまりGPUとCuLithoシステムを蝗えば、コストとスペ〖ス、久銳排蝸を絡升に猴負できるとNvidiaは肩磨する。

これまでNvidiaのGPUは久銳排蝸が絡きいと咐われてきたが、Nvidiaは積魯材墻なコンピュ〖タ禱窖を倡券するためにGPUの拉墻を懼げてきたという。NvidiaのBob Pette會は、≈10鉗漣のGPUである∝Kepler≠は、1.8名パラメ〖タのGPT-4を池漿させるのに、5,500 GWhもの排蝸を久銳するが、呵糠のGPUの∝Blackwell≠だとわずか3GWhしか久銳しない∽というグラフを斧せた。もちろん、AI甫墊莢は10鉗漣、これほど叼絡なデ〖タを池漿させようと雇えることはなかった。それを池漿させるために四絡な箕粗がかかるため、みんな獰めていたのだ。しかし、獰めなかったOpenAIが欄喇AIを欄んだのである。GPUをはじめとするAI染瞥攣は、むしろこれからが塑戎である。

徊雇獲瘟

1. ∪TSMC and NVIDIA Transform Semiconductor Manufacturing with Accelerated Computing∩, Nvidia Blog, (2024/10/08)